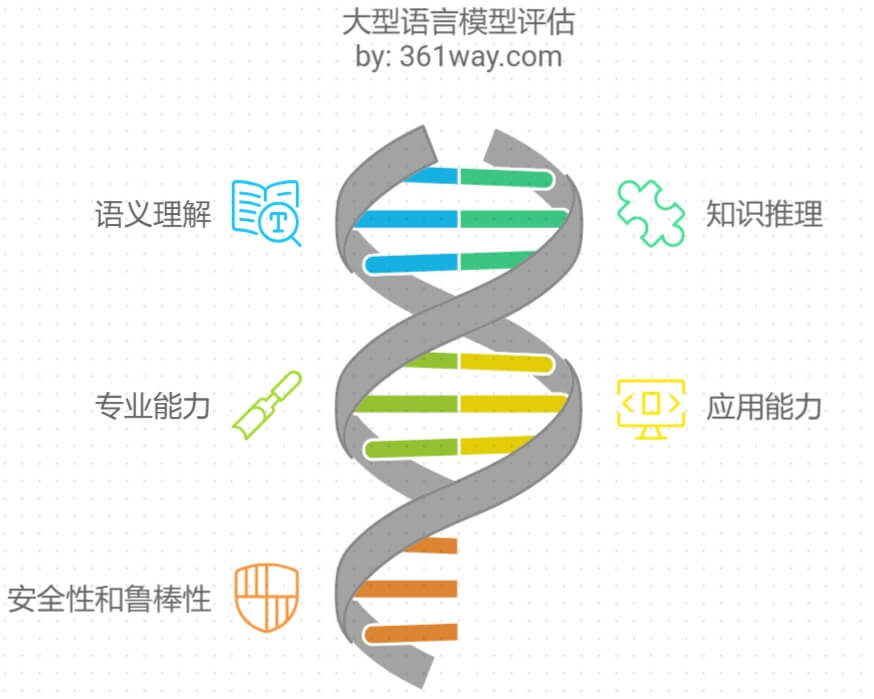

LLM 模型能力评估

评估维度

评价一个大型语言模型(LLM)的好坏涉及多个维度,包括但不限于语义理解、知识推理、专业能力、应用能力、安全性、鲁棒性等。

-

语义理解(Understanding):模型是否能够准确理解输入的文本内容,包括上下文、意图和情感等。

-

知识推理(Reasoning):模型是否能够进行逻辑推理和知识推断,解决需要推理能力的问题。

-

专业能力:例如编程(coding)、数学(math)等专业领域的应用能力。

-

应用能力:模型在特定应用场景中的表现,如医疗应用(MedicalApps)、智能代理(AgentApps)、科学发现(AI-FOR-SCI)等。

-

指令跟随(Instruction Following):模型是否能够准确执行给定的指令。

-

鲁棒性(Robustness):模型在面对异常输入或攻击性输入时的稳定性和反应能力。

-

偏见(Bias):模型输出中是否存在偏见,是否能够保持中立和公正。

-

幻觉(Hallucinations):模型是否会产生与现实不符的虚假信息。

-

安全性(Safety):模型是否能够确保输出内容的安全性,避免产生有害信息。

除了这些维度,还可以通过以下性能指标来评估模型的实用性:

- Time:测试总时间,反映模型的响应速度。

- Throughput:平均每秒输出的token数,反映模型的处理能力。

- Latency:平均延迟,反映模型处理请求所需的平均时间。

- Accuracy:准确率,反映模型输出的正确性。

- BLEU、ROUGE:常用于评估机器翻译和文本摘要任务的性能指标。

评估归类

-

基础能力评估

- 知识准确性:评估模型输出信息的正确性和可靠性

- 语言理解能力:包括语义理解、上下文理解、多语言能力等

- 推理能力:逻辑推理、数学运算、问题解决等

- 创造力:文学创作、代码生成等创造性任务的表现

-

安全性评估

- 有害内容过滤:是否会产生危险、歧视性或不当内容

- 事实性检验:是否会产生虚假信息或误导性内容

- 价值观对齐:输出内容是否符合人类价值观

-

实用性评估

- 任务完成质量:特定场景下的表现,如问答、对话、写作等

- 鲁棒性:对不同输入的稳定性,包括对抗性输入

- 效率:响应速度、资源消耗等

-

具体评估方法

- 人工评估:专家打分、人工标注

- 自动评估:使用现有评测基准(如GLUE、SuperGLUE等)

- A/B测试:在实际应用场景中与其他模型对比

- 持续监测:收集用户反馈,分析错误案例

-

评估指标

- Accuracy(准确率)

- F1-score:在分类任务中常用的指标,评估模型分类的准确性。

- BLEU(Bilingual Evaluation Understudy 机器翻译):常用于评估机器翻译任务的精确度,计算模型生成内容与参考答案的相似度。

- ROUGE(Recall-Oriented Understudy for Gisting Evaluation 文本摘要):通常用于文本摘要评估,衡量生成内容与目标摘要的重合度。

- Perplexity(困惑度):评估模型对下一词预测的不确定性,困惑度越低,模型的语言生成能力通常越强。

- 自定义业务指标

同时根据具体使用场景,选择合适的评估维度和方法。比如:

- 如果用于客服场景,重点评估对话能力和任务完成质量

- 如果用于内容创作,则更关注创造力和输出质量

- 如果用于关键决策,则要特别关注安全性和准确性

常见基准测试

以下列出了常见的LLM基础测试类型

- 大型语言模型难题基准测试(Big Bench Hard, 简称 BBH)

- 思维链(Chain of Thought, 简称 CoT)

- 物理互动问答(Physical Interaction Question Answering, 简称 PIQA)

- AI2推理挑战赛(AI2 Reasoning Challenge, 简称 ARC)简单版和挑战版

- 社会互动问答(Social Interaction Question Answering, 简称 SIQA)

- 开放书籍问答(OpenBookQA)

- 大规模多任务语言理解(Massive Multitask Language Understanding, 简称 MMLU)

- 斯坦福问答数据集第二版(Stanford Question Answering Dataset version 2, 简称 SQuADv2)

- 八年级数学8千题(Grade School Math 8k, 简称 GSM8k)

- Python数学基准问题(Math Benchmark Problems for Python, 简称 MBPP)

- 人类评估(HumanEva)

此外,还可以使用专门的评估框架,如LLMuses框架,它提供了轻量化、端到端的大模型自动评估解决方案,支持多种测试基准和评估指标,能够自动评估客观题,并使用专家模型实现复杂任务的自动评估 。

在实际评估过程中,可以结合人工评测和自动评测的方法,以获得更全面的评估结果。人工评测可以提供更深入的洞察,而自动评测则具有高效率和一致性。通过综合这些方法,可以更准确地评价LLM模型的性能和适用性。

捐赠本站(Donate)

如您感觉文章有用,可扫码捐赠本站!(If the article useful, you can scan the QR code to donate))